Lassen Sie mich eine Frage zurückwerfen: Was ist die Bitrate und Bittiefe einer Schallplatte?

Kameras sind Geräte, die so genau wie möglich das auf ihren CCD projizierte Bild reproduzieren sollen. Ein menschliches Auge ist ein weiterentwickeltes Gerät, dessen Zweck einfach darin besteht, das Überleben zu verbessern. Es ist ziemlich komplex und verhält sich oft kontraintuitiv. Sie haben nur sehr wenige Ähnlichkeiten:

- Eine optische Struktur zum Fokussieren von Licht

- Eine aufnahmefähige Membran zur Erfassung des projizierten Lichts

Die Photorezeptoren der Netzhaut

Das Auge selbst ist nicht bemerkenswert. Wir haben Millionen von Photorezeptoren, aber sie liefern redundante (und gleichzeitig mehrdeutige!) Eingaben in unser Gehirn. Die Stabfotorezeptoren sind sehr lichtempfindlich (insbesondere auf der bläulichen Seite des Spektrums) und können ein einzelnes Photon erfassen . In der Dunkelheit funktionieren sie in einem Modus namens Scotopic Vision recht gut. Wenn es heller wird, wie zum Beispiel in der Dämmerung, beginnen die Kegelzellen aufzuwachen. Kegelzellen benötigen mindestens 100 Photonen, um Licht zu detektieren. Bei dieser Helligkeit sind sowohl Stabzellen als auch Kegelzellen in einem als mesopisches Sehen bezeichneten Modus aktiv. Stabzellen liefern zu diesem Zeitpunkt eine kleine Menge an Farbinformationen. Wenn es heller wird, sättigen sich die Stabzellen und können nicht mehr als Lichtdetektoren fungieren. Dies wird als photopisches Sehen bezeichnet, und nur Kegelzellen funktionieren.

Biologische Materialien sind überraschend reflektierend. Wenn nichts unternommen würde, würde Licht, das durch unsere Fotorezeptoren dringt und auf den Augenhintergrund trifft, in einem Winkel reflektiert und ein verzerrtes Bild erzeugen. Dies wird durch die letzte Schicht von Zellen in der Netzhaut gelöst, die mithilfe von Melanin Licht absorbieren. Bei Tieren, die eine gute Nachtsicht benötigen, ist diese Schicht absichtlich reflektierend, sodass Photonen, die Photorezeptoren vermissen, die Möglichkeit haben, sie auf dem Rückweg zu treffen. Deshalb haben Katzen reflektierende Netzhäute!

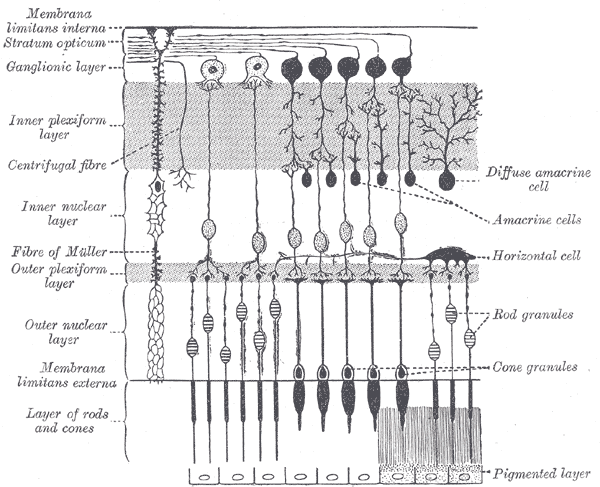

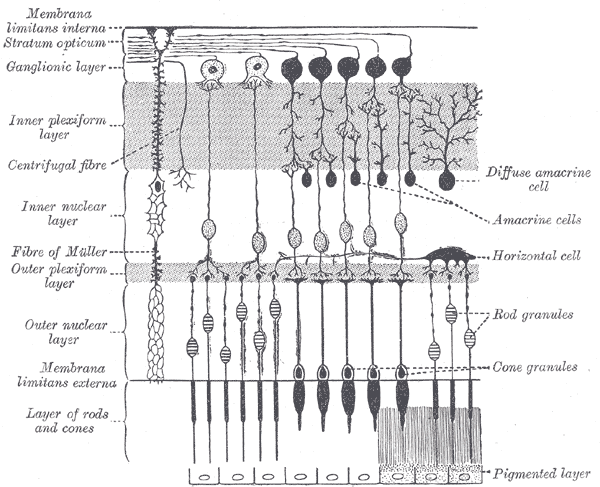

Ein weiterer Unterschied zwischen einer Kamera und dem Auge besteht darin, wo sich die Sensoren befinden. In einer Kamera befinden sie sich unmittelbar im Lichtweg. Im Auge ist alles rückwärts. Der Netzhautschaltkreis befindet sich zwischen dem Licht und den Fotorezeptoren, daher müssen Fotonen eine Schicht aus allen Arten von Zellen und Blutgefäßen passieren, bevor sie schließlich auf einen Stab oder Kegel treffen. Dies kann das Licht leicht verzerren. Zum Glück kalibrieren sich unsere Augen automatisch, sodass wir nicht auf eine Welt mit leuchtend roten Blutgefäßen starren müssen, die hin und her jagen!

Im Zentrum des Auges findet der gesamte hochauflösende Empfang statt, wobei die Peripherie immer weniger für Details und immer mehr für Farbenblindheit empfindlich wird (obwohl sie empfindlicher für kleine Mengen von Licht und Bewegung ist). Unser Gehirn geht damit um, indem wir unsere Augen schnell in einem sehr ausgeklügelten Muster bewegen, damit wir das Maximum an Details aus der Welt herausholen können. Eine Kamera ist eigentlich ähnlich, aber anstatt einen Muskel zu verwenden, tastet sie jeden CCD-Rezeptor nacheinander in einem schnellen Scanmuster ab. Dieser Scan ist viel, viel schneller als unsere Sakkadenbewegung, aber er ist auch auf jeweils nur ein Pixel begrenzt. Das menschliche Auge ist langsamer (und das Scannen ist nicht progressiv und erschöpfend), aber es kann viel mehr auf einmal aufnehmen.

Vorverarbeitung in der Netzhaut

Die Netzhaut selbst macht tatsächlich ziemlich viel Vorverarbeitung. Das physische Layout der Zellen dient zur Verarbeitung und Extraktion der wichtigsten Informationen.

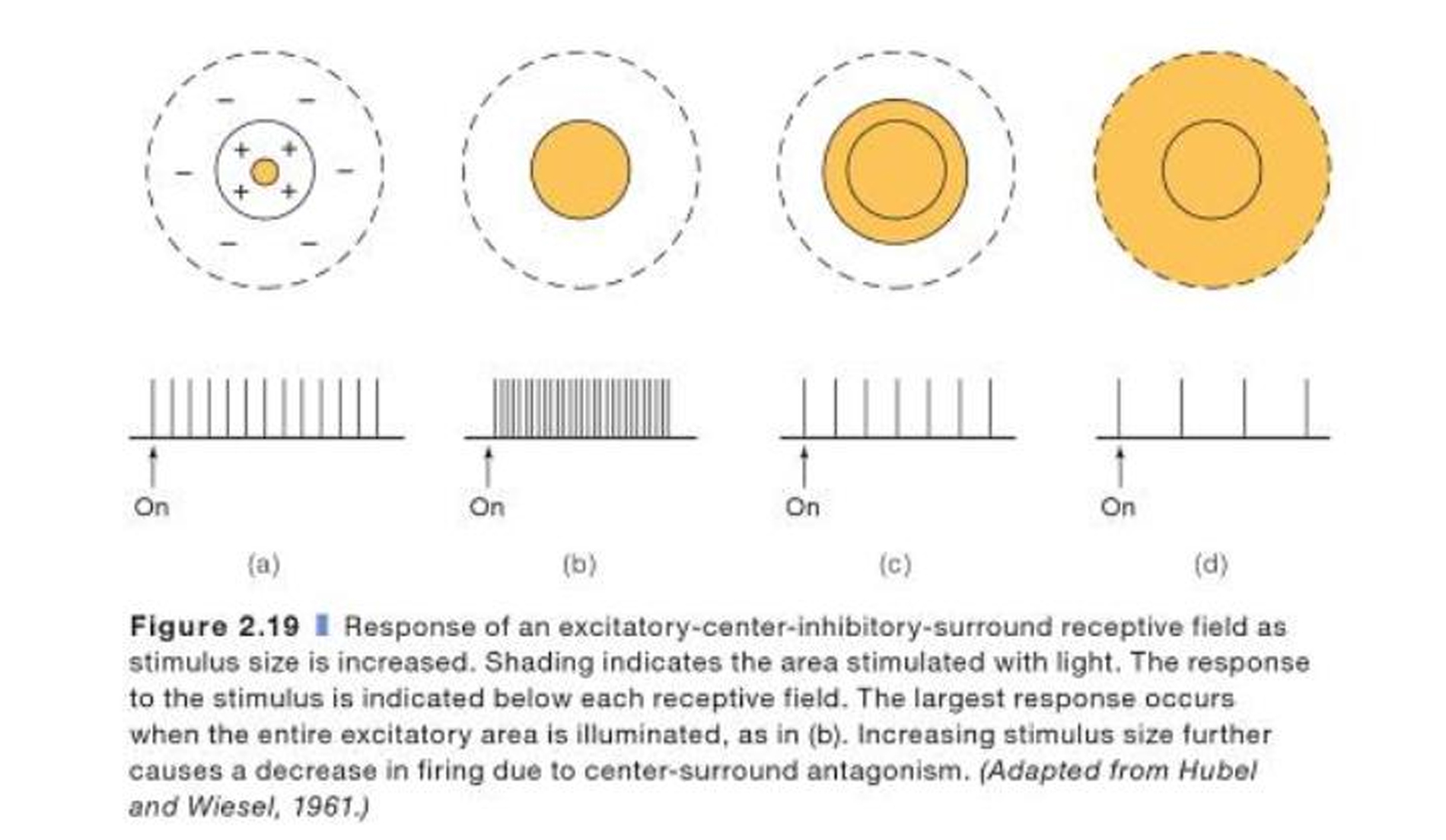

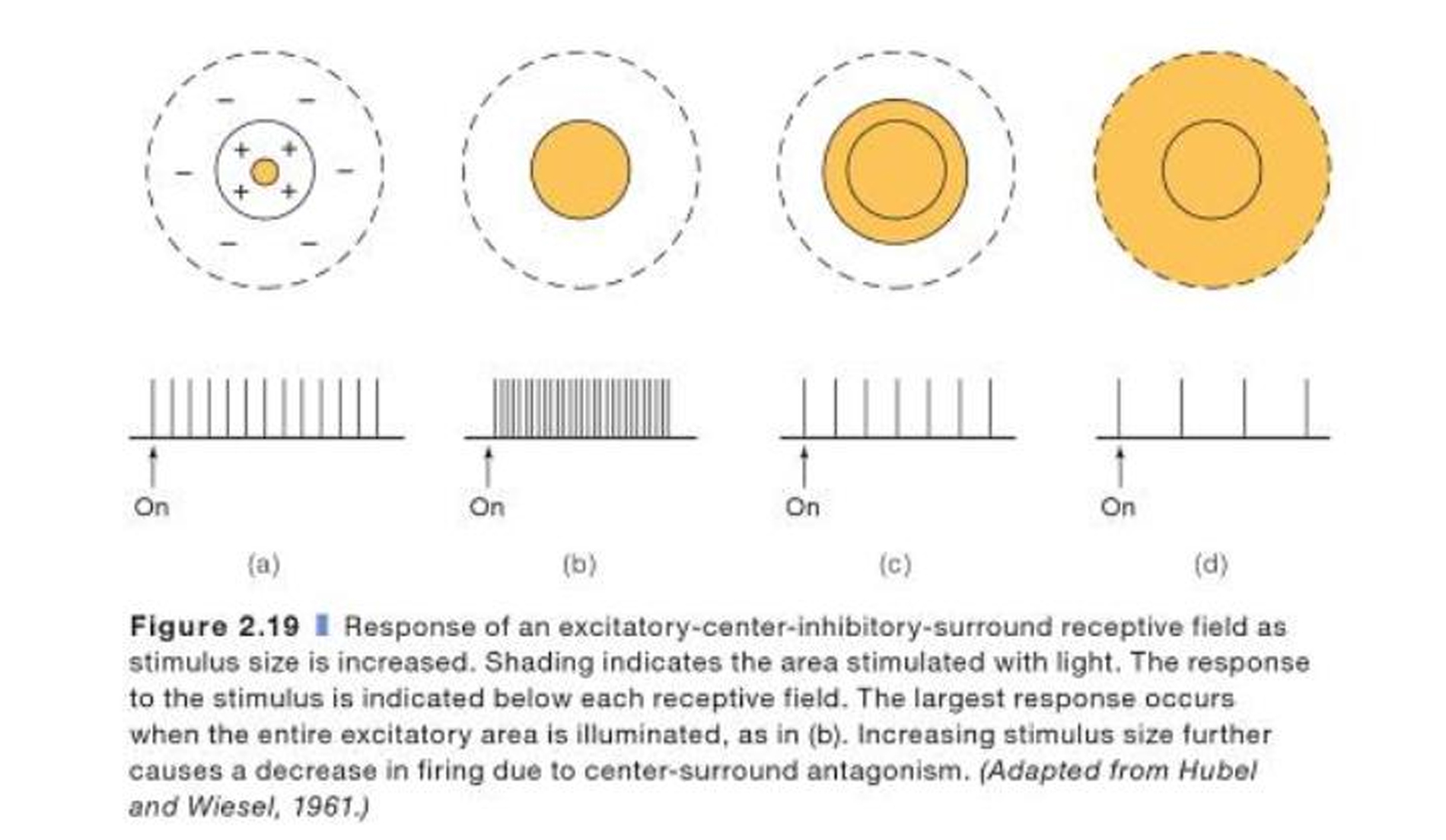

Während jedes Pixel in einer Kamera ein 1: 1-Mapping des gespeicherten digitalen Pixels aufweist (zumindest für ein verlustfreies Bild), verhalten sich die Stäbchen und Zapfen in unserer Netzhaut unterschiedlich. Ein einzelnes "Pixel" ist ein Ring von Fotorezeptoren, der als Empfangsfeld bezeichnet wird. Um dies zu verstehen, ist ein grundlegendes Verständnis der Schaltkreise der Netzhaut erforderlich:

Die Hauptkomponenten sind die Photorezeptoren, die jeweils mit einer einzelnen bipolaren Zelle verbunden sind, die wiederum mit einem Ganglion verbunden ist, das über den Sehnerv zum Gehirn gelangt. Eine Ganglienzelle empfängt Eingangssignale von mehreren bipolaren Zellen in einem Ring, der als Empfangsfeld in der Mitte umgibt. Das Zentrum, wenn sich der Ring und die Umgebung des Rings gegensätzlich verhalten. Licht, das das Zentrum aktiviert, regt die Ganglienzelle an, während Licht, das die Umgebung aktiviert, sie hemmt (ein zentrales Feld außerhalb der Umgebung). Es gibt auch Ganglienzellen, bei denen dies umgekehrt ist (exzentrisch, on-surround).

Diese Technik verbessert die Kantenerkennung und den Kontrast erheblich und opfert dabei die Schärfe. Eine Überlappung zwischen Empfangsfeldern (ein einzelner Photorezeptor kann als Input für mehrere Ganglienzellen dienen) ermöglicht es dem Gehirn, das, was es sieht, zu extrapolieren. Dies bedeutet, dass Informationen, die zum Gehirn geleitet werden, bereits stark verschlüsselt sind und dass eine Gehirn-Computer-Schnittstelle, die direkt mit dem Sehnerv verbunden ist, nichts produzieren kann, was wir erkennen können. Sie wird auf diese Weise codiert, weil unser Gehirn, wie andere bereits erwähnt haben, erstaunliche Nachbearbeitungsfunktionen bietet. Da dies nicht direkt mit dem Auge zusammenhängt, werde ich nicht viel auf sie eingehen. Die Grundlagen sind, dass das Gehirn einzelne Linien (Kanten), dann ihre Länge und dann ihre Bewegungsrichtung erkennt, jeweils in später tieferen Bereichen der Kortikalis.ventraler Strom und dorsaler Strom , die dazu dienen, hochauflösende Farben bzw. Bewegungen zu verarbeiten.

Die Fovea centralis ist das Zentrum des Auges und, wie andere betont haben, kommt der größte Teil unserer Sehschärfe von dort. Es enthält nur Zapfenzellen und hat im Gegensatz zum Rest der Netzhaut eine 1: 1-Zuordnung zu dem, was wir sehen. Ein einzelner Kegel-Photorezeptor ist mit einer einzelnen bipolaren Zelle verbunden, die mit einer einzelnen Ganglienzelle verbunden ist.

Die Angaben des Auges

Das Auge ist nicht als Kamera konzipiert, daher gibt es keine Möglichkeit, viele dieser Fragen so zu beantworten, wie Sie es möchten.

Was ist die effektive Auflösung?

In einer Kamera ist die Genauigkeit ziemlich gleichmäßig. Die Peripherie ist genauso gut wie das Zentrum, daher ist es sinnvoll, eine Kamera an der absoluten Auflösung zu messen. Das Auge ist andererseits nicht nur ein Rechteck, sondern verschiedene Teile des Auges sehen mit unterschiedlicher Genauigkeit. Anstatt die Auflösung zu messen, werden die Augen am häufigsten in VA gemessen . Eine 20/20 VA ist durchschnittlich. Eine 20/200 VA macht Sie legal blind. Eine andere Messung ist LogMAR , sie ist jedoch weniger verbreitet.

Sichtfeld?

Unter Berücksichtigung beider Augen haben wir ein horizontales Sichtfeld von 210 Grad und ein vertikales Sichtfeld von 150 Grad. 115 Grad in der horizontalen Ebene ermöglichen binokulares Sehen. Mit nur 6 Grad haben wir jedoch eine hochauflösende Sicht.

Maximale (und minimale) Blende?

Typischerweise hat die Pupille einen Durchmesser von 4 mm. Sein maximaler Bereich beträgt 2 mm (1 : 8,3 ) bis 8 mm (1 : 2,1 ). Im Gegensatz zu einer Kamera können wir die Blende nicht manuell steuern, um beispielsweise die Belichtung anzupassen. Ein kleines Ganglion hinter dem Auge, das Ciliarganglion, passt die Pupille automatisch an das Umgebungslicht an.

ISO-Äquivalenz?

Sie können dies nicht direkt messen, da wir zwei Photorezeptortypen mit jeweils unterschiedlicher Empfindlichkeit haben. Zumindest sind wir in der Lage, ein einzelnes Photon zu detektieren (obwohl dies nicht garantiert, dass ein Photon, das auf unsere Netzhaut trifft, eine Stabzelle trifft). Außerdem erhalten wir nichts, wenn wir 10 Sekunden lang auf etwas starren. Daher bedeutet zusätzliche Belichtung für uns wenig. Daher ist ISO für diesen Zweck kein gutes Maß.

Eine Schätzung der Astrofotografen im Stadion liegt offenbar bei 500-1000 ISO, wobei die Tageslicht-ISO nur 1 beträgt. Auch dies ist jedoch keine gute Messung für das Auge.

Dynamikbereich?

Der dynamische Bereich des Auges selbst ist dynamisch, da verschiedene Faktoren für das scotopische, mesopische und photopische Sehen eine Rolle spielen. Dies scheint in gut erforscht zu sein. Wie ist der Dynamikumfang des menschlichen Auges mit dem von Digitalkameras vergleichbar? .

Haben wir etwas, das der Verschlusszeit entspricht?

Das menschliche Auge ist eher eine Videokamera. Es nimmt alles auf einmal auf, verarbeitet es und sendet es an das Gehirn. Das der Verschlusszeit (oder FPS) am nächsten kommende Äquivalent ist die CFF (Critical Fusion Frequency), auch Flicker Fusion Rate genannt. Dies ist als der Übergangspunkt definiert, an dem intermittierendes Licht mit zunehmender zeitlicher Frequenz in ein einzelnes, festes Licht übergeht. Die CFF ist in unserer Peripherie höher (weshalb Sie manchmal das Flimmern alter Leuchtstofflampen nur dann sehen können, wenn Sie sie indirekt betrachten), und sie ist höher, wenn sie hell ist. Bei hellem Licht hat unser visuelles System eine CFF von etwa 60. Bei Dunkelheit kann sie bis zu 10 betragen.

Dies ist jedoch nicht die ganze Geschichte, da ein Großteil davon durch visuelle Persistenz im Gehirn verursacht wird. Das Auge selbst hat eine höhere CFF (obwohl ich im Moment keine Quelle finde, erinnere ich mich an diese in der Größenordnung von 100), aber unser Gehirn verwischt die Dinge, um die Verarbeitungslast zu verringern und uns mehr Zeit zu geben einen vorübergehenden Reiz zu analysieren.

Versucht, eine Kamera und das Auge zu vergleichen

Augen und Kameras haben völlig unterschiedliche Zwecke, auch wenn sie oberflächlich dasselbe zu tun scheinen. Kameras basieren absichtlich auf Annahmen, die bestimmte Arten von Messungen vereinfachen, während für die Entwicklung des Auges kein solcher Plan ins Spiel kam.