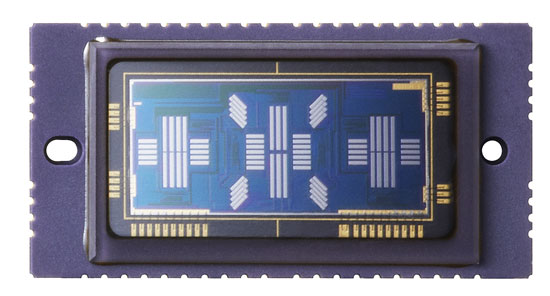

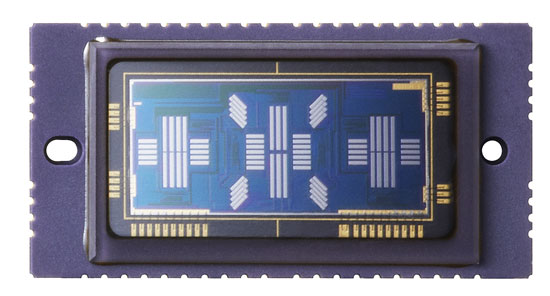

Der Phasendetektions-Autofokus misst die horizontale Verschiebung zwischen den auf den AF-Sensor projizierten Helligkeitsmustern. Um die Verschiebung zu messen, werden Paare von eindimensionalen Arrays von monochromen Pixeln verwendet. So sieht der AF-Sensor in der Canon 5D mkIII aus:

Sie können viele verschiedene Pixelzeilen sehen, die von verschiedenen vom Benutzer auswählbaren AF-Messfeldern verwendet werden. Im Prinzip können Sie Pixelzeilen auf dem Hauptbildsensor verwenden, um genau den gleichen Job auszuführen.

Dieser Ansatz hat einige Vorteile:

Sie haben keine Probleme, wenn der Hauptbildsensor und der AF-Sensor falsch ausgerichtet sind, da sie ein und dasselbe sind.

Sie vermeiden die Komplexität der Sekundärspiegel und die Kosten des AF-Chips selbst.

Die Verwendung des Hauptsensors weist Nachteile auf.

In einem Kommentar unter der verknüpften Antwort wird darauf hingewiesen, dass der AF-Sensor eine Linse benötigt, um Lichtstrahlen auf die entsprechende Position des Sensors zu fokussieren, da dieser kleiner als der Hauptsensor ist (Kursivschrift ist meine eigene Annahme).

Ihre Annahme ist nicht ganz richtig. Es hat nichts mit einem kleineren AF-Sensor zu tun, die AF- "Objektive" sind eigentlich ein Objektiv mit einem wellenförmigen B-förmigen Profil. Dieses Objektiv fokussiert Licht, das von beiden Seiten des Objektivs kommt, auf verschiedene Teile des AF-Sensors.

Sie benötigen immer noch eine Art Objektiv, um diese Aufgabe zu erledigen, wenn Sie den Hauptbildsensor verwenden, und es müsste beim Aufnehmen eines Fotos zusammen mit dem Reflexspiegel aus dem Weg schwingen, was eine komplizierte mechanische Anordnung innerhalb der Kamera erfordert. Dies ist der Hauptnachteil dieses Ansatzes, obwohl es andere Hindernisse gibt:

Die Bildsensorpixel befinden sich hinter Farbfilterarrays, die die Lichtmenge, die sie erreicht, um bis zu zwei Drittel reduzieren. Dies könnte möglicherweise die Leistung bei schlechten Lichtverhältnissen verringern, es würde Ihnen jedoch ermöglichen, die Phasenmessungsanpassung in Farbe durchzuführen, um weniger falsche Ergebnisse zu erzielen (es ist weniger wahrscheinlich, dass Sie beispielsweise ein Detail aus dem Vordergrund mit einem Detail aus dem Hintergrund verwechseln Auch Farbe kann verwendet werden, um die Verfolgung zu unterstützen.

Die Größe, der Abstand und die Empfindlichkeit der Pixel unterscheiden sich zwischen den beiden Sensoren. Wenn Sie also beide mit einem Sensor verwenden, müssen Kompromisse eingegangen werden.

Der Hauptsensor müsste viel länger eingeschaltet sein, damit mehr Energie aus den Batterien fließt. Wie Stan betont, müsste der Verschluss auch während des AF geöffnet sein, so dass das Schließen vor dem Belichten zu einer Verzögerung führen würde.

Schließlich datiert der Phasenerkennungs-AF digitale Bildsensoren vor, sodass die gesamte Technologie und das gesamte Werkzeug zur Durchführung des AF unter Verwendung eines separaten Sensors bereits vorhanden und gut entwickelt sind.

Allerdings haben die Hersteller eine etwas andere Methode zur Phase erfassen AF entwickelt , das macht den Hauptsensor verwenden. Es wurde für spiegellose Kameras entwickelt, die nicht über einen dedizierten AF-Sensor verfügen und sich traditionell auf die langsamere Kontrasterkennungsmethode mit dem Hauptsensor verlassen.

Anstelle eines Paares von AF-Linsen im Lichtweg, um Licht von beiden Seiten des Objektivs auf verschiedene Teile des AF-Sensors zu lenken, können Paare von regulären Mikrolinsen mit abwechselnd verdunkelten Hälften verwendet werden, um einen ähnlichen Effekt zu erzielen (Pixel links) halb ausgeblendet empfängt meistens Licht von der rechten Seite des Objektivs und umgekehrt.

Dies ermöglicht einen hybriden AF-Ansatz mit einer Kombination aus Phase (um dem richtigen Fokus nahe zu kommen) und Kontrasterkennung (um das Ergebnis zu optimieren).