Die vorherigen Herausforderungen im Bereich des Golfsports mit neuronalen Netzen ( dies und das ) haben mich zu einer neuen Herausforderung inspiriert:

Die Herausforderung

Finden Sie das kleinste neuronale Feedforward-Netzwerk, sodass bei einem beliebigen 4-dimensionalen Eingabevektor mit ganzzahligen Einträgen in das Netzwerk ausgibt mit einem Koordinatenfehler von weniger als .

Zulässigkeit

Für diese Herausforderung wird ein vorwärts gerichtetes neuronales Netzwerk als eine Zusammensetzung von Schichten definiert . Eine Schicht ist eine Funktion , die durch eine Matrix von Gewichten , einem Vektor , spezifiziert ist von Verzerrungen und eine Aktivierungsfunktion , die koordinativ angewendet wird: b ∈ R m f : R → R

Da Aktivierungsfunktionen für eine bestimmte Aufgabe optimiert werden können, müssen wir die Klasse der Aktivierungsfunktionen einschränken, um diese Herausforderung interessant zu halten. Folgende Aktivierungsfunktionen sind zulässig:

Identität.

ReLU.

Softplus.

Hyperbolischer Tangens.

Sigmoid.

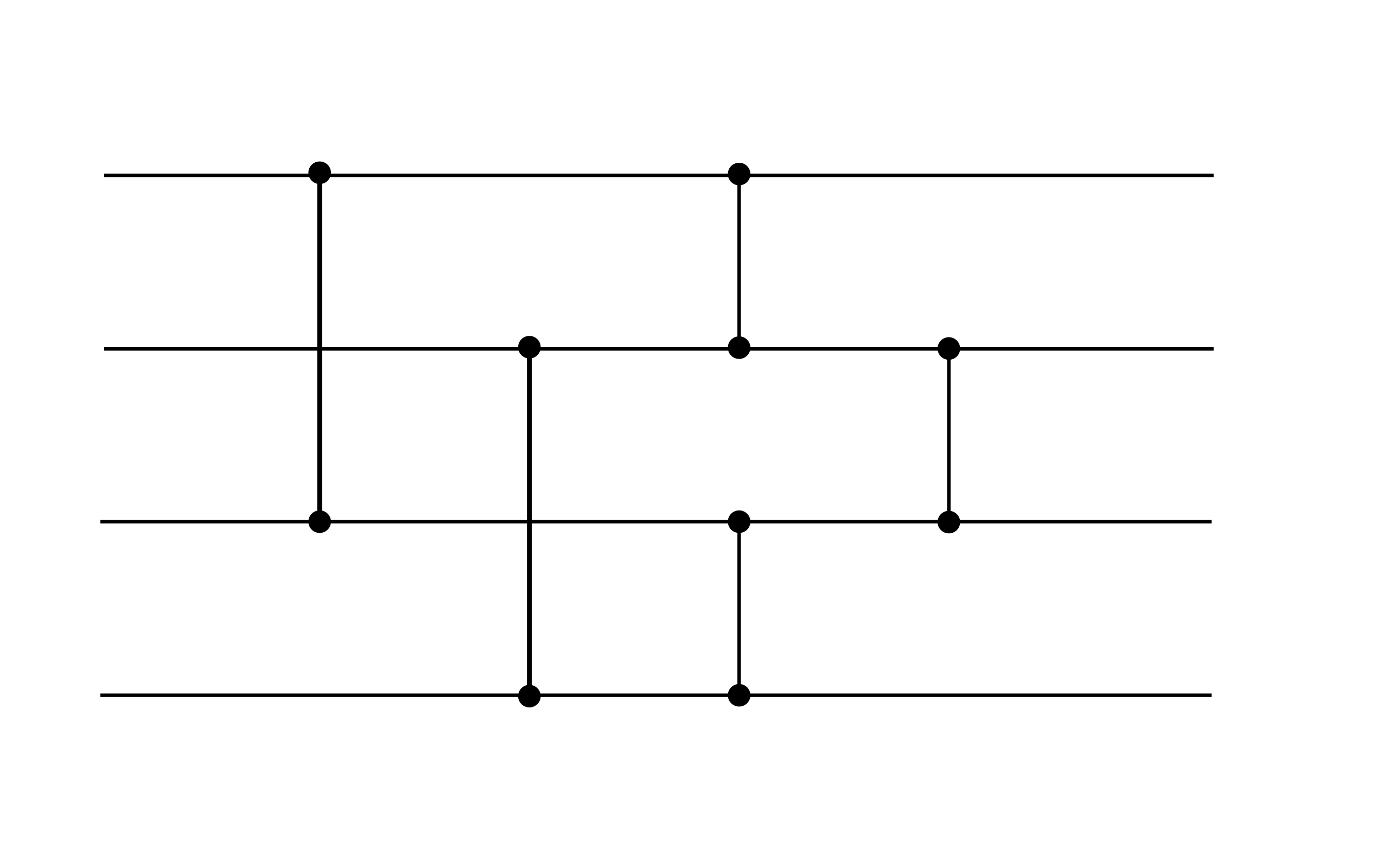

Insgesamt hat ein zulässiges neuronales Netz für einige die Form , wobei jede Schicht durch Gewichte , Vorspannungen und eine Aktivierungsfunktion spezifiziert ist aus der obigen Liste. Das folgende neuronale Netz ist beispielsweise zulässig (obwohl es das Leistungsziel dieser Herausforderung nicht erfüllt, kann es ein nützliches Gadget sein):

Dieses Beispiel zeigt zwei Schichten. Beide Schichten haben keine Vorspannung. Die erste Schicht verwendet die ReLU-Aktivierung, während die zweite die Identitätsaktivierung verwendet.

Wertung

Ihre Punktzahl ist die Gesamtzahl der Gewichte und Verzerrungen ungleich Null .

(ZB hat das obige Beispiel eine Punktzahl von 16, da die Vorspannungsvektoren Null sind.)